-

智能模型

智能模型 核心软件

核心软件 数据库

数据库

了解清数新闻,掌握AI前沿资讯

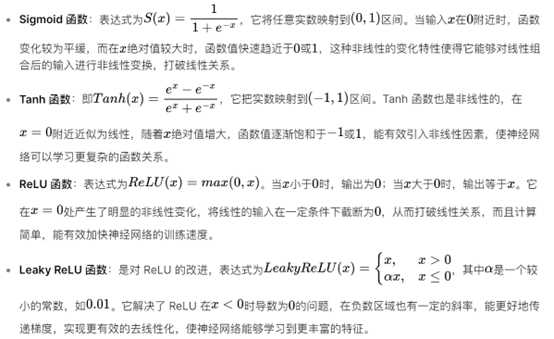

在深层神经网络中,激活函数是实现去线性化的关键要素,以下将围绕常见激活函数及其去线性化原理、作用和优势等方面展开介绍:

常见激活函数及其去线性化原理

激活函数去线性化的作用

增加模型表达能力:使神经网络能够拟合任意复杂的非线性函数,理论上可以逼近任何连续函数。通过引入激活函数的非线性变换,神经网络可以学习到数据中的复杂模式和关系,例如在图像识别中,能够识别出各种形状、颜色和纹理的组合,在自然语言处理中,能理解语言中的语法结构和语义信息。

实现特征分层提取:在深层神经网络中,每一层的激活函数将上一层的输出进行去线性化处理后,作为下一层的输入。这样,神经网络可以在不同的层次上提取到不同层次的特征,从简单的底层特征逐渐组合成复杂的高层特征,例如在图像识别中,底层可以提取边缘、角点等简单特征,高层则可以识别出物体的整体形状和类别。

激活函数去线性化的优势

提高模型的泛化能力:相比线性模型,经过激活函数去线性化后的神经网络能够更好地适应不同的数据分布和特征,不容易过拟合,在测试集和实际应用中表现出更好的泛化性能,能够对未见过的数据进行准确的预测和分类。

支持反向传播算法:激活函数的可微性使得在神经网络训练过程中可以使用反向传播算法来计算梯度,从而更新网络的权重参数。通过反向传播,误差可以从输出层反向传播到输入层,使得每一层的权重都能够根据误差进行调整,以最小化损失函数,实现模型的优化。

严正声明:本网站中所有图文版权归青岛清数科技有限公司所有,严禁商用,如学习交流,请注明图片来源于本公司,如发现私自商用,必追究法律责任。

版权所有©2022 青岛清数科技有限公司 | 鲁ICP备2023028303号-1 | 鲁公网安备 37020602000239号

扫一扫关注公众号